Die Website für Google optimieren ist ja nicht so schwer, wenn man die SEO-Grundlagen kennt. Doch einfach ist es manchmal auch, sich die Google-Rankings mit nur wenigen Klicks komplett zu ruinieren. Verscherze es dir nicht mit Google, wobei nicht mal Böswilligkeit schuld sein muss. Damit du diese Fehler nicht machst, erzähle ich dir von ihnen. Deal?

Inhaltsverzeichnis

Was meine ich mit unsichtbar? Wenn du Suchmaschinen nicht erlaubst, deine Seite zu lesen (crawlen), dann können sie diese auch nicht in den Index aufnehmen. Es findet keine Indexierung und damit keine Rankings statt. Schade, Schokolade, aber dann bringt auch SEO nichts, wenn du alle Bots ausschließt.

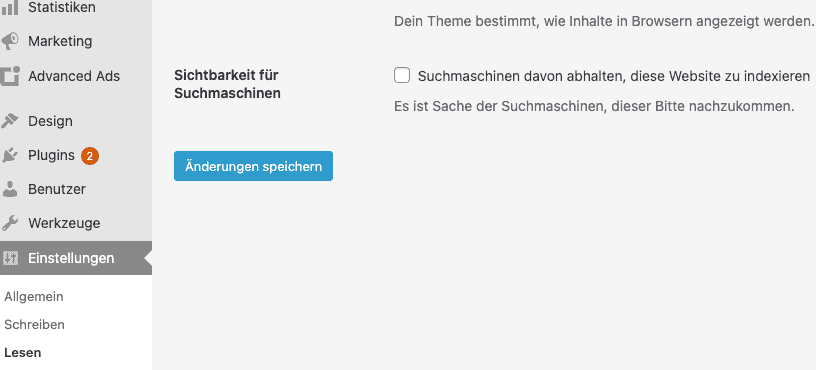

Ein beliebter SEO-Fehler ist hier das Setzen des berüchtigten Hakens in WordPress:

Unter Einstellungen > Lesen findest du den Punkt "Sichtbarkeit für Suchmaschinen". Dieser Haken darf nur dann gesetzt sein, bevor du deine Website veröffentlichst. Danach muss er zwingend entfernt werden.

Wenn du dich nun fragst, was ist denn schon wieder eine robots.txt Datei? Dann kann ich nur auf deine Website verweisen. Generell erstellen CMS (Content Management Systeme wie WordPress) eine solche Datei. Standardmäßig sind alle Bots und Suchmaschinen erlaubt, alle dürfen deine Website besuchen und lesen.

Dann hole dir unsere gratis Wunschlisten-App bitte.kaufen (⬅️ Wunschliste anlegen)

Doch manchmal probiert man dann doch den ein oder anderen Tipps aus und dann steht in der robots.txt Datei auf einmal "disallow" drin, also Bots nicht erlauben, bestimmte Webseiten zu sehen.

Der folgende Code bedeutet übersetzt, dass du allen Crawlern erlaubst, deine Website zu lesen. Sternchen dienen als Platzhalter. Hinter Disallow steht keine weitere Anweisung. Das bedeutet: Crawle alles! Außerdem verweist die Datei auf die Sitemap, die Google beim Crawling unterstützt.

User-agent: *

Disallow:

Sitemap: https://domain.de/sitemap_index.xmlMit folgendem Code werden alle Crawler ausgeschlossen, also Google, Bing und sämtliche Programme, die deine Website lesen wollen.

User-agent: *

Disallow: /Mit dem Code werden nur Google-Crawler ausgeschlossen. Das gilt es natürlich auch zu vermeiden, wenn du in Google Rankings bekommen möchtest.

User-agent: Googlebot

Disallow: /Tipp: Checke deine eigene robots.txt Einstellungen. Die robots.txt liegt, sofern vorhanden, immer im Root-Verzeichnis, also in der ersten Ebene:

Dann hole dir unsere gratis Wunschlisten-App bitte.kaufen (⬅️ Downloads)

Teste deine robots.txt im Tester-Tool:

Wie gerne hat es Google, wenn viele Websites auf deine Seite verlinken? In der Theorie liebt Google Backlinks. Und hier kommt, du errätst es schon, das Aber. Google liebt natürliche Links. Das sind Links, die Webmaster nicht selbst aufbauen.

Bei der näheren Betrachtung ist das auch logisch: Echte Empfehlungen kommen von Herzen. Das ist wie mit dubiosen Produkten vom Online-Marktplatz, denen man die gekauften Bewertungen schon beim ersten Satz ansehen kann. Die bringen Kunden nichts.

Das genau will Google jedoch: Kunden glücklich machen. Das geht auf Basis von gekauften Links, also Empfehlungen, nicht. Links kaufen und besser ranken klappte früher tadellos, inzwischen ist Google da noch mehr hinterher, künstlichen Linkaufbau aufzudecken.

Im schlimmsten Fall kann diese Art der Manipulation dazu führen, dass deine Website abgestraft wird. Dann findest du einen Hinweis in der Google Search Console. Als Ergebnis kann entweder deine ganze Domain oder nur ein Bereich in Google quasi unauffindbar gemacht werden. Wer auf Seite 5 in Google landet, existiert für die Nutzer:innen nicht mehr.

Dann hole dir unsere kostenlose Wunschzettel-App bitte.kaufen (⬅️ Downloads)

Ich kann nur davon abraten, Links zu kaufen. Ich bin sehr sicher, dass über kurz oder lang der Schwindel auffliegt und hier immer die Gefahr droht, erwischt zu werden. Und zudem kannst du dich fragen: Was würde im Zweifel der gekaufte Link bringen? Echte Empfehlungen durch echte Links sollen Besucher auf deine Website bringen: können gekaufte Links aus der Grabbelkiste das erreichen?

Uhhh, ein Klassiker! Was passiert, wenn du aus Versehen deine Inhalte doppelt und dreifach in deinem System anlegst, bzw. dein System das für dich macht? Duplicate Content sind doppelte Inhalte.

Das passiert super schnell. In Online-Shops führt es zu Duplicate Content, wenn du ein Produkt unter mehreren URLs verfügbar machst, es also von zwei Kategorien erreichbar ist und es mehrere URLs hat. Dasselbe gilt für Farbvarianten in Shops. Doch auch auf Websites ohne Shop kann es schnell zu doppelten Inhalten kommen.

Hast du daran gedacht, eine Weiterleitung einzurichten, wenn deine Website über http und über https erreichbar ist? Hast du große Textblöcke auf mehreren Seiten verteilt? Das sind die typischen Duplicate Content Fehler, es gibt jedoch weit aus mehr.

Das Problem, das Google hat, ist: Welche Seite ist denn am relevantesten? Wenn es mehrere gleiche Seiten gibt, kann sich das auf das Ranking auswirken. Im Worst Case sackt deine gut rankende Seite ab, weil Google mehrere URLs für die Suchanfragen zur Auswahl hat. Dann leiden beide URLs und keine taucht mehr in den Top 5 in Google auf. Upsi!

Als SEO-Expertin ist das aus meiner Sicht der gravierendste Fehler, der dein Ranking versauen kann. Vielleicht hast du sogar schon gute Google-Rankings mit Teilen deiner Seiten erreicht, hurra! Dann heißt es, dranbleiben und die Seiten im Auge behalten und stets verbessern: Mach SEO!

Es heißt ja auch Suchmaschinenoptimierung und nicht Ich-hau-mal-einen-Text-raus-friss-das-Google! Andere Unternehmen machen immerhin auch mit im Ranking-Spiel und aktualisieren brav die Inhalte. Warum sollte die Suchmaschine dann deinen 5 Jahre alten Text vorn anzeigen?

Dann hole dir unsere gratis Wunschlisten-App bitte.kaufen (⬅️ Wunschliste anlegen)

Wenn du noch gar kein SEO machst, fange mit den Grundlagen an. Dann vermeidest du auch die groben SEO-Fehler! Lade dir hierzu gerne mein SEO-Workbook für 0 € herunter. Darin bekommst du die Basics und Aufgaben. Mit dem Workbook startest du entspannt und einfach in die erste Optimierung deiner Website!

Merke dir den Beitrag auf Pinterest! 🙂

Wer schreibt hier?

Sarah Depold